阿尔法公社:目前中国的生成式AI已经完成了基础大模型的积累阶段(各大厂和头部创业公司都已有大模型),下一步将进入AI的大规模应用阶段。但是AI的安全问题不解决,无论是终端用户,还是企业级用户始终会对采用AI心存疑虑。

解决AI的安全问题,将推动AI的进一步普及,创造更多价值。随着AI在C端和企业端的广泛应用,AI安全这个刚需的需求量将大增。

AI正被越来越多的企业采用,为他们带来价值,甚至成为一些企业的核心能力。但是,针对AI的安全仍然很不完善,也让很多企业一边对AI的“超能力”兴趣盎然,一边又对AI是否安全心存疑虑。如果说数据安全还可以用私有化部署来解决,但如果AI模型本身被侵入,岂不是授人以入侵自己隐私的高效工具?

一家致力于AI系统安全的创业公司Protect AI已经开始在模型层面保护AI的安全,它由曾经管理AWS全球AI和ML业务的连续创业者Ian Swanson创立,帮助企业在大规模采用AI的同时抵御安全漏洞、数据泄露和其他新兴威胁。

今年7月,Protect AI获得由Evolution Equity Partners和Salesforce Ventures共同领投,Acrew Capital、Boldstart Ventures、Knollwood Capital和Pelion Ventures等投资机构参投的3500万美元A轮融资。

在2022年12月,他们曾获得由Acrew Capital和Boldstart Ventures共同领投的1350万美元种子轮融资,目前,它的累计融资额达到4850万美元。

Protect AI的创始人Ian Swanson表示:“我们看到了AI可以带来的价值,但也看到了这些系统固有的风险。我们的使命是帮助客户构建一个更安全的AI驱动的世界。”

来自AWS和Oracle的豪华创业团队要从模型层面保护AI的安全

对于想使用AI能力的企业来说,AI/ML的安全挑战变得越来越复杂,各种基础模型和外部的第三方训练数据集(许多受欢迎的AI开源项目已发现可被用来攻击的代码),加剧了这种复杂性。

大多数组织缺乏检测机器学习供应链中的威胁和漏洞的技能和资源,而且大多数CISO(首席信息安全官)还没有将机器学习特定的扫描和AI漏洞修复列为优先事项。

技能和资源的缺乏导致了盲点,并产生了独特的AI安全挑战,使组织面临一系列问题:监管不合规、个人身份信息泄露、数据操纵、模型污染和声誉风险。

Endor Labs(一家专注于开源软件安全的公司)最近的一项调查发现,在Github排名前100的AI开源项目中有52%存在漏洞。

据Synopsys(新思科技)调查,大数据、AI、BI和ML代码库中近80%的代码依赖于开源组件,其中超过40%的代码库存在高风险漏洞。

企业对AI的加速采用,除了AI本身的吸引力外,还在于MLOps技术帮助降低门槛:通过提供维护和监控大规模AI/ML系统的流程、治理和程序,它能够将AI模型投入生产流程的成本降低。

但是Protect AI的团队注意到,AI/ML带来了一种新的、独特的攻击面,而目前市场上已有的网络安全解决方案并未解决这个问题,AI需要新的安全方法。

注:网络安全中的“攻击面”指的是一个系统或网络中可以被潜在攻击者利用的所有可能的点和路径。

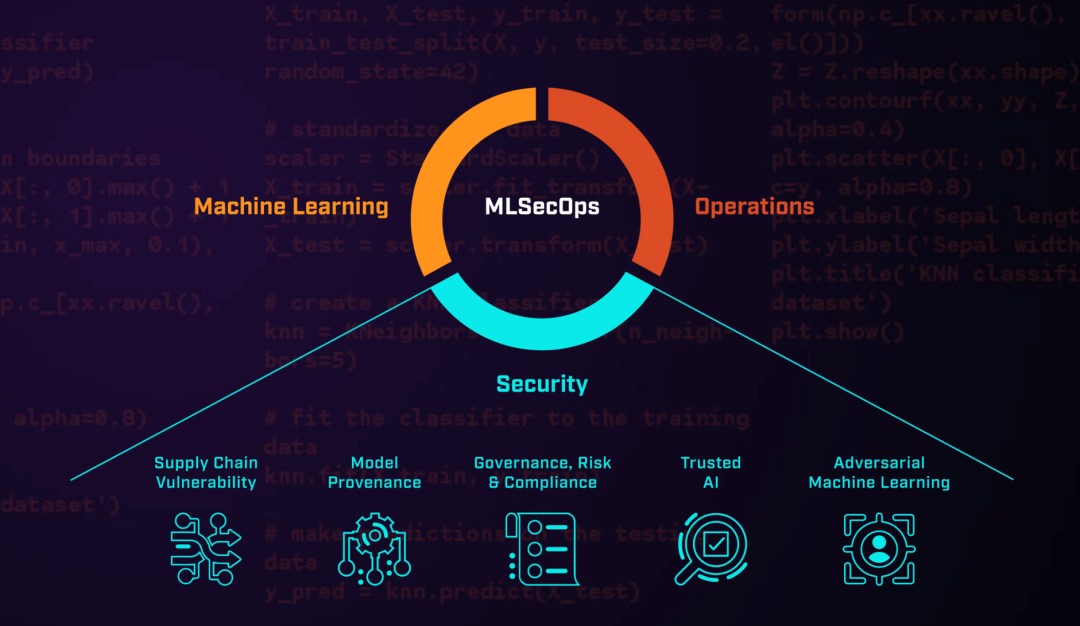

于是Protect AI将安全性纳入AI工具和流程的工作流中,让安全性从一开始就伴随AI流程,而不是成为事后的考虑因素。这样,MLOps(机器学习+运营)就升级成了MLSecOps(机器学习+安全+运营),创造了一个新的领域。

Protect AI由Ian Swanson与Daryan Dehghanpisheh、Badar Ahmed共同创立。Swanson曾领导AWS的全球AI和ML业务,也是连续创业者。Swanson创立的上一家创业公司DataScience.com正是MLOps领域技术最先进的公司之一,后来被Oracle收购,Badar Ahmed和Swanson曾经在DataScience.com及Oracle共事。

而Daryan Dehghanpisheh则是Ian Swanson在AWS的老同事,当时Swanson领AWS的AI客户解决方案团队,Dehghanpisheh则是AI架构师。

可以看出,这是一个“豪华”创业团队,既有过硬的技术,又有创业经历,还在大厂管理过大团队,帮助大量客户处理过问题。所以Salesforce Venture的投资人表示,他们对Protect AI最大的信心来源是出色的团队,其次是AI安全这个增长迅速且容量庞大的潜在市场。

Protect AI的种子轮投资人,Acrew Capital的创始合伙人Mark Kraynak也表示:“AI/ML是一种全新的应用类别和底层基础设施,就像移动网络、物联网和Web3一样。新的应用生态系统的安全遵循相同的循环:了解漏洞,找到它们,再添加上下文理解和优先级,最后实现自动化修复。Protect AI的团队从MLOps出发,进化到MLSecOps,我们对这一进化感到兴奋。”

从开源软件到首个MLSecOps平台

现在黑客们针对AI的攻击有多可怕?以机器学习系统中最受欢迎的工具之一MLflow(它可用于管理端到端的机器学习生命周期)举例。

攻击者们可以通过MLflow的漏洞,在未经认证的情况下远程读取MLflow服务器中用户的任何文件。MLflow的另一个漏洞,则能让攻击者直接控制MLflow服务器上的所有AI模型和数据。

目前,Protect AI拥有旗舰安全平台AI Radar,开源产品NB Defense,以及全球首个人工智能和机器学习漏洞赏金平台huntr。

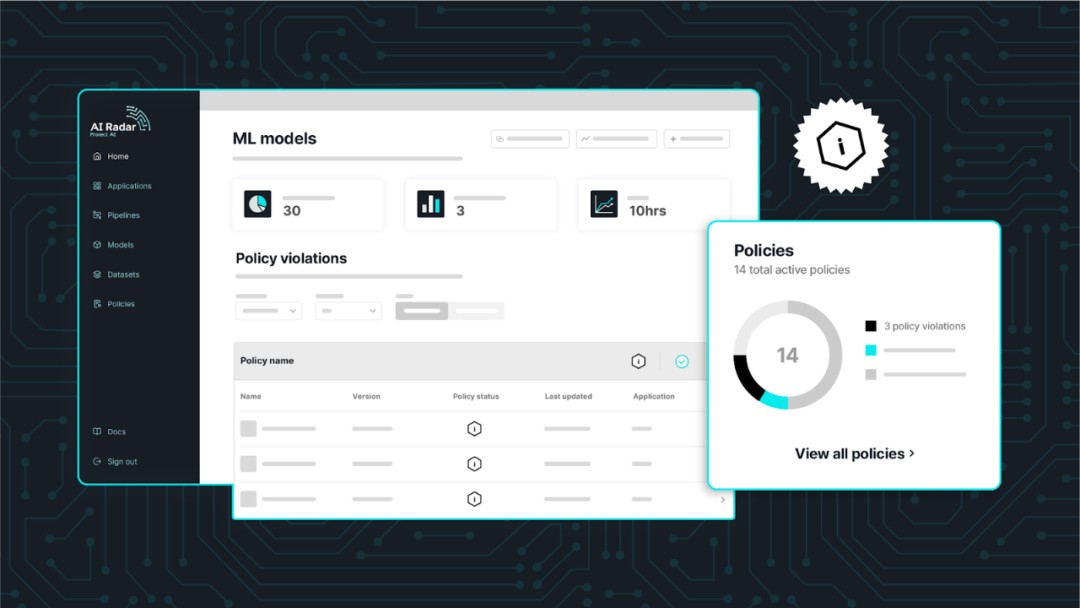

AI Radar

AI Radar是Protect AI的旗舰产品,也是行业内首个MLSecOps平台。这个平台主要解决的关键挑战是:让企业用户的AI系统更可视化,更方便审计,也更好管理。

AI Radar使组织能够通过评估其ML供应链的安全性并迅速识别和减轻风险,从而更安全地部署AI。它通过实时监控和洞察ML系统的攻击面,生成和更新防篡改的ML物料清单(MLBOM),与SBOM不同,它提供了ML系统中所有组件和依赖关系的列表,使客户完全了解AI/ML的来源。它还能跟踪公司的“软件供应链”组件:运营工具、平台、模型、数据、服务和云基础设施。

该平台使用集成的模型扫描工具来检测大模型和其他ML推理工作负载中的安全政策违规、模型漏洞和恶意代码注入攻击。此外,AI Radar可以与第三方AppSec和CI/CD编排工具以及模型稳健性框架集成。

AI Radar使整个AI系统,可观察,可管理,可审计,不再是一个黑盒子。弥合了AI团队和应用安全专业人员之间的鸿沟。

许多大型企业使用多个ML软件供应商,如Amazon Sagemaker、Azure Machine Learning和Dataiku,从而导致他们的ML管道有各种配置。

Ian Swanson强调AI Radar保持供应商中立,并无缝集成所有这些不同的ML系统,创建一个统一的“单一视窗”。通过这种方式,客户可以轻松获取任何ML模型的位置和来源以及其创建中使用的数据和组件的关键信息。

Ian Swanson表示,ProtectAI的下一步重点是为AI Radar找到产品和市场契合点(PMF),它的早期客户包括AI基础模型供应商和MLOps平台提供商,以及金融服务、医疗保健、生命科学等领域的公司。

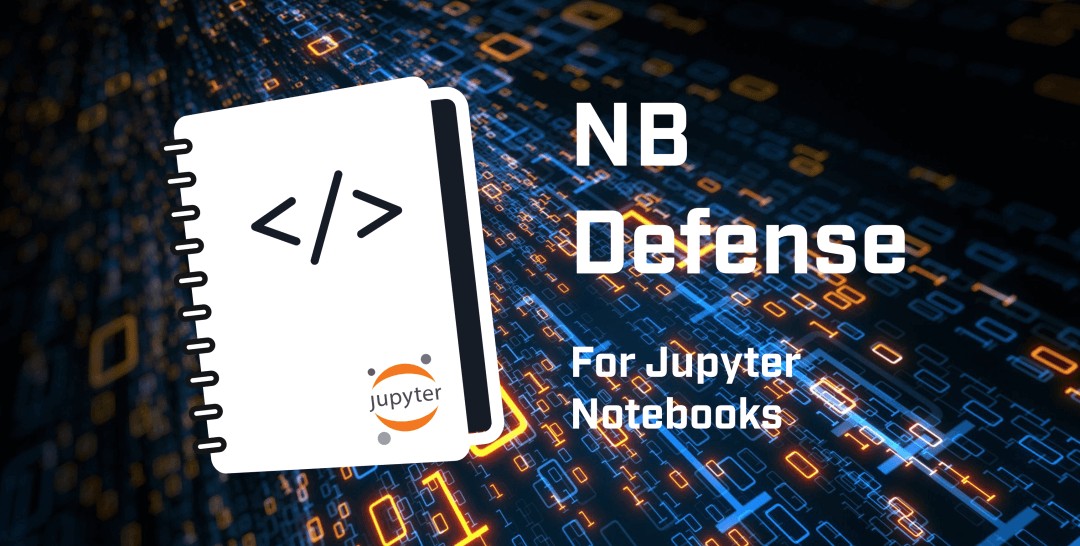

NB Defense

Protect AI推出的第一个产品是NB Defense,这是一个开源应用程序,旨在解决AI开发平台Jupyter Notebook中的漏洞。

AI开发者使用Jupyter Notebook来创建和分享包含实时代码、函数、可视化、数据和文本的文档。研究机构发现,未妥善保护的Jupyter Notebook文件可能会容易受到基于Python的勒索软件和加密货币挖矿攻击。

Protect AI使用NB Defense扫描了1000多个公共Jupyter Notebook,并发现了许多泄露的个人身份信息和可能被攻击者利用来攻击云系统的关键漏洞,包括获得对敏感数据库的访问权限。

而NB Defense是针对Jupyter Notebook的安全解决方案,它创建了一个从传统安全功能到Jupyter Notebook扫描的转换层,并且生成安全报告,报告中包含指向Jupyter Notebook中问题区域的特定上下文链接,以便进行修复。

NB Defense目前提供免费许可,AI开发者们可以轻松安装NB Defense。

huntr

huntr是全球首个AI/ML漏洞赏金平台,安全研究人员可以在这个平台/社区上发现、披露、修复AI和ML安全威胁,并获得奖励。

huntr的前身是huntr.dev,它由Adam Nygate于2020年创立,拥有超过一万名专注于开源软件(OSS)的安全研究员的庞大网络,一直处于OSS安全研究和开发的前沿。

huntr是Protect AI的MLSecOps社群的一个重要组成部分,由此也可以看出Protect AI拥抱安全开发者和建立生态的决心。

Protect AI的威胁研究负责人Chloé Messdaghi强调了该平台的精神:“我们相信透明度和公平的报酬。我们的使命是削减噪音,为安全研究人员提供一个能够认可他们的贡献、奖励他们的专业知识,并培养协作和知识共享社群的平台。”

AI安全未来会是企业的刚需

安全对于AI的重要性已经不言而喻,无论是对于C端用户还是企业客户,都是刚需。随着AI在企业流程中渗透得越来越深,创造越来越多的价值,它的安全性会越被企业的高层重视。

海外的某知名投资机构,近日也推出一篇关于AI安全的文章,文章提到了AI安全的两大重点:云安全模型,AI的可观察性、可管理性和可审计性;还有几个重要模块:数据来源安全,AI Agent身份验证,工具链和供应链的风险防范,MLSecOps,模型版本管理,以及数据中毒防范,模型盗窃防范。

Protect AI的重点就是AI的可观察性,可管理性和可审计性,推出了MLSecOps平台,也能防范模型盗窃。而在其他的几个方向,仍然有大量的创业机会,海外也已经有不少创业公司在AI安全赛道耕耘。

例如Hidden Layer,它可以在不需要访问任何原始数据或供应商模型的情况下保护AI模型免受攻击,目前融资额600万美元。

Robust Intelligence的产品可以对AI模型进行安全方面的压力测试,目前融资额3000万美元。

CalypsoAI做的是验证和监控AI应用的工具,目前融资额2300万美元。

目前中国的生成式AI已经完成了基础大模型的积累阶段(各大厂和头部创业公司都已有大模型),下一步将进入AI的大规模应用阶段。

解决AI的安全问题,将推动AI的进一步普及,创造更多价值。随着AI在C端和企业端的广泛应用,AI安全这个刚需的需求量将大增。

而这也将产生众多的创业机会,值得期待。

本文由阿尔法公社原创。