编者按:本文来自微信公众号 阿尔法公社(ID:alphastartups),作者:阿尔法公社,创业邦经授权发布。

上周,Meta发布了大语言模型Llama 2,它的能力相比前作增长不少,但其最大的意义在于开源和开放商用,这让有志于在自己业务中使用生成式AI能力的创业者们节省了99%的大语言模型训练算力时长成本。他们只需花费1%的算力时长,就可以在开源可商用的大语言模型上微调出符合自己行业需求的模型。这从根本上降低了大模型创业的准入门槛。

在生成式AI创业从基础大模型转向垂直应用的趋势下,有不少创业公司致力于帮助应用侧的客户和用户以尽量低的成本使用大语言模型的能力,Replicate就是这个方向上的一家典型公司。它打造了一个开源的AI模型托管云平台,帮助中小企业实现模型的快速交付,用户可以在平台上部署,微调AI模型,还能根据业务量快速扩展自己的模型。

Replicate在2023年2月和7月分别完成了两轮融资,2月,它获得由a16z领投的1250万美元A轮融资,7月,又获得3200万美元的新融资(投资者未披露),它的其他投资者还包括红杉资本,Y Combinator以及Andrej Karpathy(OpenAI科学家),Richard Socher(You.com创始人),Solomon Hykes(Docker创始人),Thomas Dohmke(GitHub CEO)等,可以看出,这家公司受到了硅谷顶级投资机构和企业家们的集体青睐。

连续创业者与资深人工智能专家联手,让普通软件工程师也能玩转大模型

在计算领域,其实很少有新的基础构件,应用程序本质上都是网络、存储和计算的某种组合。但是像Stable Diffusion和ChatGPT这样的视觉或语言大模型却真的代表了一个全新的基础构件。将这些大模型整合到软件中,开发者可以实现包括文本,视觉,语音等多模态内容的生成,这在以前是不能实现的。这种转变的级别不仅是将软件从PC转移到移动设备(iPhone带来的转变),而是代表一种全新类型的软件。

大模型的能力毋庸置疑的强大,但是普通软件开发者将AI大规模运行到生产环境中时,仍面临一系列难题:如何托管模型,模型出问题时该怎么办,以及如何随着时间推移构建模型的差异化——针对大模型的清晰抽象和简单工具还没有诞生。

Replicate的两位联合创始人Ben Firshman和Andreas Jansson,从头像就可看出他们的极客范儿。

Replicate的两位联合创始人Ben Firshman(CEO)和Andreas Jansson(CTO)想要解决这个问题,而他们也有经验和技术基因去解决它。

Ben Firshman是一位连续创业者,Replicate是他第4次创业,他在Docker担任产品总监时设计了Docker Compose,现在这个工具被数百万开发者使用,他对开发者体验有着超乎寻常的理解力。

Andreas Jansson曾担任Spotify的高级机器学习工程师,他具备大规模部署AI模型的经验,并从0设计过创新的AI工具。

“对于软件工程师,AI目前还太难用,你必须对AI具有非常深刻的认识。整个软件行业都受到了机器学习专家短缺的阻碍(约3000万软件工程师对比约50万机器学习工程师)。我们让软件工程师可以在没有任何经验的情况下,只需几行代码就可以使用AI的能力,这样他们就可以构建带有AI的产品,并将其应用到业务上。”Firshman在谈到创业初衷时这样说。

Replicate的种子轮和A轮投资人,红杉资本合伙人Stephanie Zhan则表示:“Replicate提供了一种简单、快速的方式,让任何人都可以在云上运行生成式AI模型。开发者不必为GPU烦恼,也不必为昂贵的AWS付费,他们只需要一行代码就可以在云中部署AI模型,按秒计费。

除了在开源生态系统中使用最好的模型,Replicate的平台还允许公司运行自己的定制模型,它会自动打包、优化并部署这些模型——将过程从几周缩短到几分钟,并减少对基础设施团队帮助的需求。

我们很高兴能通过这轮A轮融资深化与Ben和Andreas的合作,AI将是下一个十年最重要的主题——由数据规模、生成式AI模型的新技术突破和计算的进步推动——而在这个软件2.0世界的基础设施堆栈被编写的过程中,我们相信Replicate将扮演一个基础的角色。”

一个云平台,让AI模型部署时间从几周降到几分钟

Replicate的核心产品理念是,所有开源AI模型都应该能在一个地方找到,并且易于使用。开发者应该能在没有任何机器学习工作、托管设置的情况下,立即启动并运行大语言模型。将几个模型组合成一个管道应该很容易。并且,当应用程序规模扩大时,开发者应该能够使用简单的工具进行微调并托管自己的模型。

Replicate的产品是一个开源的AI模型托管云平台,它的几个主要功能是:

现有大模型的整合与引入

企业用户可以使用几行代码就在平台上运行机器学习模型,而无需了解任何机器学习的工作原理。

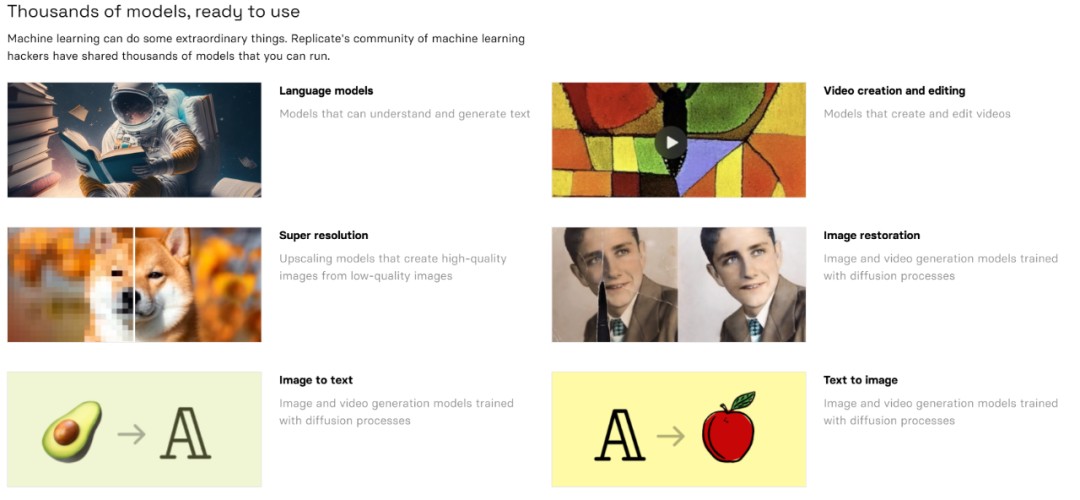

针对需求相对简单的用户,Replicate提供了上千个不同的AI模型在线使用或者简便地导入到自己的程序中,包括语言模型、视频创作与编辑、超分辨率、图像修复、图片转文字、文字转图像等六大功能,最火爆的模型已经被在线使用了超过9000万次。

针对需求更高的深度用户,他们可以借助Replicate的模型库以及Next.js和Vercel等工具开发自己的项目。截止目前,已经有很多AI工程师使用Replicate来制作自己的项目,例如将开源基础大模型进行特定方向的微调(目前开发者们已经能在Replicate平台上微调 Llama 2大模型),其中优秀项目包括roomGPT、 Scribble Diffusion等。

帮助用户部署人工智能大模型

部署人工智能大模型模型的传统方法是,开发人员必须先将模型及其支撑组件手动打包到软件容器中,然后再部署。Replicate 开发了一种名为Cog的开源工具,简化了这项任务。

Cog目前内嵌在Replicate的云平台中,用户可以通过比以往更少的定制化工作来配置容器。用户在云平台仅通过几行代码就能运行特定的AI模型,整个过程只需要几分钟,与以前的部署方法相比是指数级的下降。

Replicate不仅提供了云平台,还给出了非常详细的模型部署教程。目前,cog在GitHub上获得了超过5200颗星。

帮助快速扩展人工智能模型规模

对于中小企业,大规模部署机器学习模型不止会遇到cog解决的部署问题,同样关键的问题是如何扩大其规模以达到商用标准。在扩大规模的时候,要处理的问题涵盖API服务器、依赖关系、模型权重、CUDA、GPU、批处理等。

当用户在Replicate平台上部署机器学习模型,平台可以从硬件和软件两个层面帮助其扩展规模。

软件上,用户既可以使用现成的开源模型,也可以大规模部署自定义私有模型——只要使用Cog定义的模型,Replicate都可以自动为其生成可扩展的API服务器,并部署在大型GPU集群上。

当用户部署的模型获得大量流量时,Replicate会自动扩展模型以满足需求。如果部署的模型没有获得任何流量,replicate就会将规模缩减至零,并且不会向用户收取任何费用。

硬件上,Replicate目前提供七种不同级别的硬件设施以供用户部署其模型,平台会以秒级别的精度计算用户的部署时间并计费,价格区间在0.0002美元/秒至0.00471美元/秒之间。同时,平台还支持对于合规性、安全性或对SLA(服务等级协议)有特定需求的企业级客户提供定制软硬件解决方案。

更低的进入门槛让AI应用创业迎来春天

我们曾经说过,得人才者得模型,得模型者得天下, 现在再加一句,产品致胜。把模型训练、服务产品化, 靠产品化实现规模化、低成本,是AIGC创业的王道。

此前,Llama 2帮助创业者节省了99%的训练模型算力时长,Replicate这样的创业公司又帮助创业者把模型部署的时间成本降低了99%,再加上99%的企业需要第三方模型服务,这些都是创业的机会。

当然,Replicate并不是唯一帮助企业降低AI使用准入门槛的,像Hugging Face(它已经是估值20亿美元的独角兽)和OctoML等公司也在做类似的事。而且不知是巧合还是必然,这三家公司都来自开源社区。这些来自开源社区的创业者,更理解开发者们的痛点,也更具有开源精神,能够打造真正符合开发者需求的产品和平台。

随着Llama 2对于开发和商用的开源,利用AI大模型的能力做垂直应用的公司将如雨后春笋般涌现出来,而帮助它们降低使用AI大模型能力门槛的公司,使这些AI应用创业公司们更早迎来春天。

本文为专栏作者授权创业邦发表,版权归原作者所有。文章系作者个人观点,不代表创业邦立场,转载请联系原作者。如有任何疑问,请联系editor@cyzone.cn。