编者按:本文来自微信公众号 硅基研究室(ID:gh_cef05ac13977),作者:白嘉嘉,创业邦经授权转载

摩根士丹利分析师刚给英伟达贴上“泡沫”的标签,英伟达就拿出了最新一代GH 200 Grace Hopper超级芯片平台,证明这股AI热并非摇摇欲坠的空中楼阁。

美东时间8月8日,在洛杉矶的SIGGRAPH大会上,英伟达发布新一代GH200 Grace Hopper超级芯片平台,该平台依托于搭载全球首款HBM3e处理器的Grace Hopper超级芯片(后称GH200)。

图源:SIGGRAPH大会

英伟达表示,新平台旨在处理世界上最复杂的生成式AI工作负载,涵盖大型语言模型、推荐系统和矢量数据库,将提供多种配置。

除了超级芯片平台,英伟达还发布了5款硬件新品和简化企业级AI开发过程的AI workbench服务等内容。

其中,5款硬件新品分别是搭载全新L40S Ada GPU的新款OVX服务器、搭载RTX 6000 Ada GPU的全新RTX工作站,以及3款高端桌面工作站GPU。

超级芯片GH200,大小模型都能用

本次发布会上,黄仁勋照旧搬出了那句标志性的促销口号,“买得越多,省得越多”。

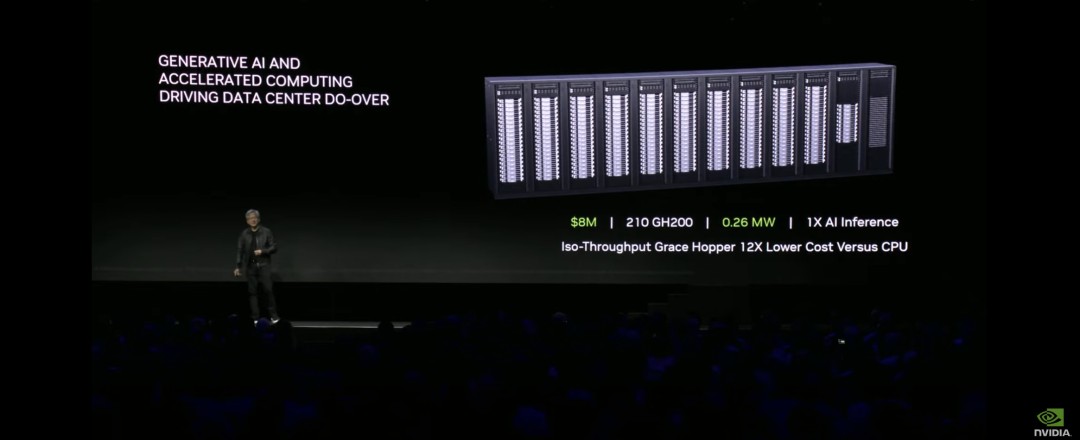

同样花1亿美金,过去能买8800块x86 CPU组成的数据中心,功耗是5MV。

在GH200面世后,这1亿美金发挥出了更大的价值。通过购买2500块GH200组成的Ios-Budget数据中心,不仅可以将功耗降低到3MV,AI推理性能更是达到了前者的12倍,折合能效提升20倍。

同等推理性能的情况下,Iso-Troughput数据中心只需用到210块GH200,功耗是0.26MW,成本只有x86 CPU数据中心的二分之一,仅800万美元。

图源:SIGGRAPH大会

即便和英伟达的拳头产品——在eBay上涨到4.5万美元的H100相比,GH200的表现同样让人惊艳。

基于全球最快内存HBM3e,GH 200内存容量高达141GB,提供每秒5TB的带宽。每个GPU容量达到H100的1.7倍,带宽达1.55倍。

对于行业来说,更大的容量和更高的运行速度,意味着未来可以让模型驻留在单个GPU上,而不必需要多个系统或GPU才能运行。

但这并不意味着GH 200就不适用于生成式AI的巨型模型,英伟达新发布的NVIDIA NVLink™服务器设计,对GH200进行了拓展。

NVIDIA NVLink™将允许Grace Hopper超级芯片可以与其他超级芯片连接组合,这一技术方案为GPU提供了完全访问CPU内存的途径。

同时,英伟达表示,目前正在开发一款新的双GH200基础NVIDIA MGX服务器系统,将集成两个下一代Grace Hopper超级芯片。

在新的双GH200服务器中,系统内的CPU和GPU将通过完全一致的内存互连进行连接,这个超级GPU可以作为一个整体运行,提供144个Grace CPU核心、8千万亿次的计算性能以及282GB的HBM3e内存。

AI Workbench,让人人都能做大模型

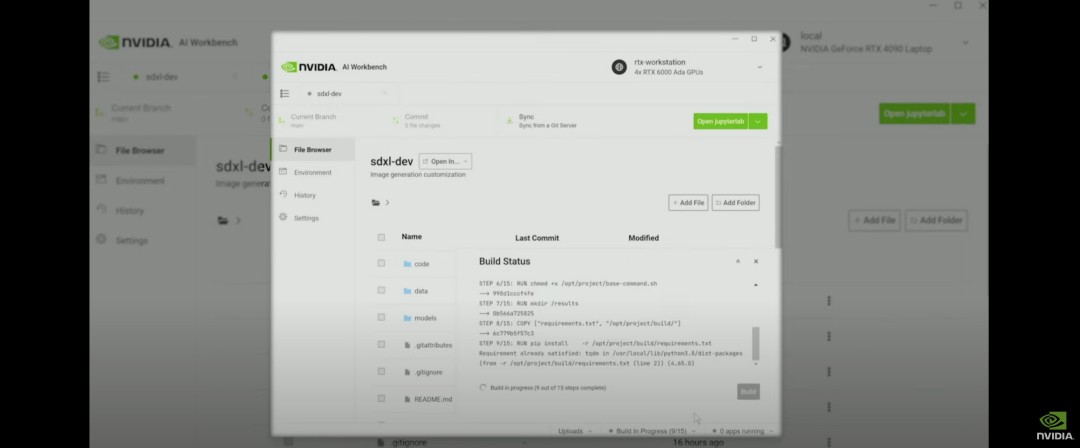

除了全新的超级芯片平台,另一项对行业起到促进作用的内容是AI Workbench。

英伟达认为,当前企业级AI的开发过程太过繁琐和复杂,不仅需要在多个库中寻找合适的框架和工具,当项目需要从一个基础设施迁移到另一个基础设施时,过程可能会变得更加具有挑战性。

简单来说,AI Workbench实现了企业级模型的快速打包和搬运,让开发者既可以在个人电脑、笔记本电脑或工作站上快速创建、测试和定制生成式AI模型,也可以在必要时重新将其拓展到数据中心、公有云或NVIDIA DGX Cloud。

具体到使用上,AI Workbench提供了一个简单的用户界面,开发人员能够将模型、框架、SDK等信息从开源资源整合到统一的工作区中,可以在本地计算机上运行并连接到HuggingFace、Github以及其它流行开源或商用AI代码储存库。

图源:SIGGRAPH大会

英伟达表示,使用 AI Workbench 的一些主要优势包括:

易于使用的开发平台。AI Workbench 通过提供单一平台来管理数据、模型和计算资源,支持跨机器和环境的协作,从而简化了开发流程。

与 AI 开发工具和存储库集成。AI Workbench 与 GitHub、NVIDIA NGC 和 Hugging Face 等服务和 Git 服务器集成,用户可以使用 JupyterLab 和 VS Code 等工具跨平台和基础设施进行开发,具有高度的可重复性和透明度。

增强协作。该项目结构有助于自动化围绕版本控制、容器管理和处理机密信息的复杂任务,同时还支持跨团队协作。

访问加速计算资源。AI Workbench 部署是客户端-服务器模型,用户能够开始在其工作站中的本地计算资源上进行开发,并随着训练作业的规模扩大而转向数据中心或云资源。

Omniverse,构建工业元宇宙

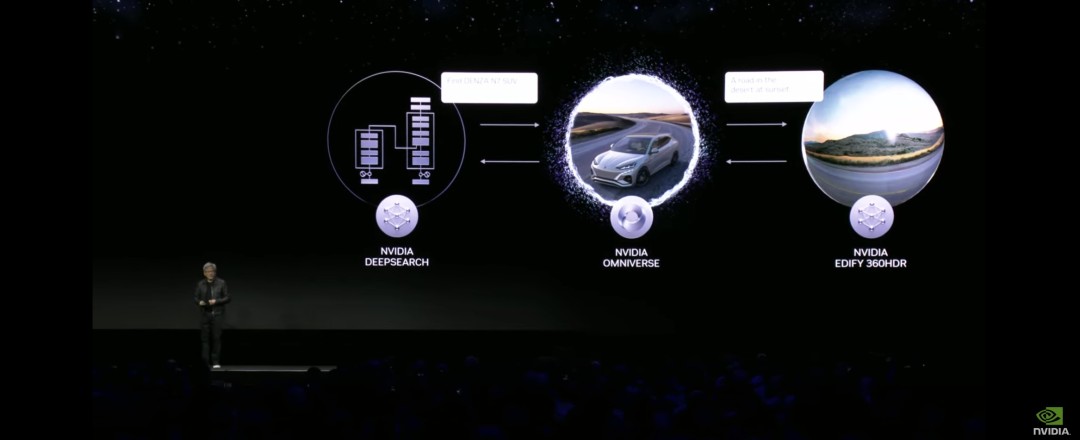

具体到工业领域,演讲的另一位主角——Omniverse平台,以及该平台的基础——开源通用场景描述框架OpenUSD,打开了工业元宇宙和数字孪生场景开发的想象力。

图源:SIGGRAPH大会

一句话介绍,Omniverse平台是一个被用于跨3D工具的连接、描述和模拟,能加快构建虚拟世界和工业数字化高级工作流程的软件平台。

新平台的亮点包括更新开发原生OpenUSD应用及扩展的引擎——Omniverse Kit,以及英伟达Omniverse Audio2Face基础应用和空间计算功能的更新。

Omniverse和模拟技术副总裁 Rev Lebaredian表示,更新后的Omniverse让开发人员可以通过OpenUSD利用生成式AI强化他们的工具,并且让工业企业能构建更大、更复杂的世界级模拟,作为其工业应用的数字测试场。

为了方便程序员使用,英伟达推出了一些Omniverse云API,其中包括基于NVIDIA Nemo框架的大语言模型ChatUSD、用于检查兼容性和生成实时的完全路径跟踪的交互式USD文件渲染的RunUSD、语义搜索服务DeepSearch。

黄仁勋宣布,比亚迪和梅赛德斯·奔驰合资的豪华电动汽车品牌腾势(DENZA)已与营销及通信巨头WPP合作,在NVIDIA Omniverse Cloud上构建和部署其下一代先进汽车配置器。

除了上述介绍的这些新产品及更新,英伟达还推出了配备全新NVIDIA L40S GPU的NVIDIA OVX服务器,可用于加速AI训练和推理、3D设计和可视化、视频处理和工业数字化等复杂的计算密集型应用;

搭载RTX 6000 Ada GPU的全新NVIDIA RTX工作站,系统可配置NVIDIA AI Enterprise或Omniverse Enterprise软件,以支持各种苛刻的生成式AI和图形密集型工作负载;

企业软件平台NVIDIA AI enterprise 4.0,可提供生产就绪型生成式AI工具,并提供了可靠的生产部署所需的安全性和API稳定性。

显然,这位大模型时代的宠儿正在用硬实力证明,英伟达并不只是芯片生产商,而是不折不扣的模型开发平台,而层出不穷的新产品和服务,则一次又一次地坐实了企业作为AI普惠核心推动者的身份。

日前,AMD发布了对标H100的MI300X,在容量和带宽上实现了反超,意图在“缺芯”的背景下分食英伟达的市场,但随着GH200发布,AMD的算盘是否还能在极致性价比的冲击下起效?

一个现实是,在群狼环伺的AI战场上,硬件、生态两手抓的英伟达,目前还没发现真正的对手。

参考资料:

英伟达超级芯片GH200 Grace明年Q2投产,黄仁勋称“AI时代,英伟达的技术可以替代传统数据中心”|王铮Silvia

老黄又来“抢钱”:英伟达再推超强芯片平台,守住万亿芯片老大擂台|硅星人

昨夜,黄仁勋甩出最强生成式AI处理器,全球首发HBM3e,比H100还快|智东西

NVIDIA Keynote at SIGGRAPH 2023

本文为专栏作者授权创业邦发表,版权归原作者所有。文章系作者个人观点,不代表创业邦立场,转载请联系原作者。如有任何疑问,请联系editor@cyzone.cn。