编者按:本文来自微信公众号 格隆汇APP(ID:hkguruclub),作者:弗雷迪,创业邦经授权转载。

ChatGPT发布一年后,围绕生成式AI的热潮已经席卷科技企业,手机、PC厂商都在争先将AI融入产品中,由此,也让新一轮的设备硬件内卷序幕,被快速拉开。

自8月份华为将盘古大模型接入手机智能助手后,小米、OPPO、ViVo、荣耀均快速跟上队形,生成式AI俨然是未来几年新机发布必不可少的一个卖点。

当手机厂商都在抢着落地大模型时,PC也开启了自己的AI革命。率先提出“Copilot”的微软已经将Open AI的大模型融入到操作系统,以及生产力工具当中。

生成式AI从云端加速走向终端的同时,对设备AI处理能力的要求倒逼了硬件架构的加速升级。

在手机端,高通在下半年发布的骁龙8 Gen 3处理器,已经可以支撑运行高达100亿参数的大模型。只需0.6秒,就能生成1张不错的图片,甚至比国内很多大模型都快又好很多。

在PC端,今天在“AI Everywhere”发布会上,英特尔拿出了代号Meteor Lake的新一代酷睿™Ultra处理器,首次内置了人工智能加速引擎NPU。

与云端训练场景截然不同的是,大模型推理阶段对算力资源的要求并不是那么苛刻,但要接入更牛的模型,对芯片计算能力,内存带宽,电池能耗的挑战增加,消费端用户要充分感受AI带来的质变,成本和差异化体验是最大的变量。

这其中,就是各家设备商们可以各项神通的演武场。

他们等这样一个机会,等了太久。

交互革命

AI大模型对于智能终端带来最大的帮助,体现在交互价值上。近几年终端一直缺少这种颠覆性的变化,所以当Open AI拿出以GPT为底座的ChatGPT,不少人感觉好像回到了2007年iPhone问世的时刻。

落地终端最清晰的终极愿景,就是AI Agent,看过科幻片的都懂。

对此,联想CEO杨元庆的定义是,部署在终端设备的大模型使用我们存储在本地服务器上的个人数据进行推理,接入了大模型的设备仿佛用户的数字延伸,通过对我们使用设备的模式学习和模仿成为了我们的智能共同体,他称为“AI Twin”。

在AIPC概念出来之前,手机助手也贴着智能的标签被手机厂商当成卖点,实际上都还只是编程指令式的机械问答,智障助手一样,纯粹在占用我们的内存空间。

GPT的诞生,才让人类第一次感受到,原来与智能助手沟通可以这么的丝滑,借助大模型检索、分析、逻辑推理的能力,我们能够更自然随意地和AI助手进行交流,指派更复杂的指令。

首先,时效性决定了很多应用场景的存在意义。端侧AI纯靠设备处理器提供支撑,在无网或弱网条件下也能正常运行,也就不存在网络延迟等不良体验的干扰。

同时,我们的短信、照片、聊天记录、备忘录、日程形成了可供大模型检索的向量数据库,无需重新训练即可结合文本生成能力形成最终输出,并且这些数据在加工的同时不需要上传至云端,保障了隐私安全。

此外,多模态能力可以给用户带来丰富的交互体验。AI大模型在自然语言处理、图像识别和语音识别等方面的泛化能力在设备端能够创造更多有想象力的应用场景。

例如VIVO接入蓝心大模型的小V,提到手机上万张的图片管理中,用户可以尝试直接以语义识别的方式说出照片的内容理解,让小 V 在相册中主动识别有对应内容的照片。

从厂商的角度,用户体验和成本直接影响了设备商对大模型技术的介入程度。

一来,通用大模型的在云端训练和推理本就十分耗费资源,不光算力,数据传输还要消耗网络带宽、存储等大量资源,光是云端的算力成本已经让Open AI这种初创公司感到昂贵,ChatGPT仅维持用户访问的一个月成本就达到了1000万美元。

他们投资的AI硬件公司的第一代产品AI Pin,每月要交24美元的订阅费才能调用AI功能,这对几乎从不在手机上订阅任何服务的用户来说,要让他们额外花钱用AI助手,几乎不可能。

终端手机厂商不敢为了一个不成熟的技术应用就躬身投入,相比之下,边缘设备犹如“毛细血管”,替中心节点承接了一部分计算需求,“云”与“端”的相互配合,或许是大模型加速应用开枝散叶的关键。

部分手机厂商如华为、VIVO、OPPO走的就是“云”“端”协同的路线,做出从十亿到千亿等不同参数规模的模型矩阵,结合参数规模和硬件特性,手机或能做出差异化的特色。

在华为的展示里,用户已经可以直接和小艺同学用自然语言交互,沟通自己的需求,而华为再通过元服务拉起相关的app,满足用户需求。

另一边,小米目前主要做的是端侧大模型,最新在手机本地跑通了13 亿参数模型,部分效果可以媲美60亿参数在云端运行的结果。

如果最终大模型能以标准化的接口调用设备里的所有功能,未来每个应用甚至都不需要花心思做界面,AI助手就是人机交互界面,变成了所有应用的入口。届时,用户和交互界面的关系,设备商,操作系统开发者和第三方应用的关系都将得到重塑。

如何给大模型“瘦身”?

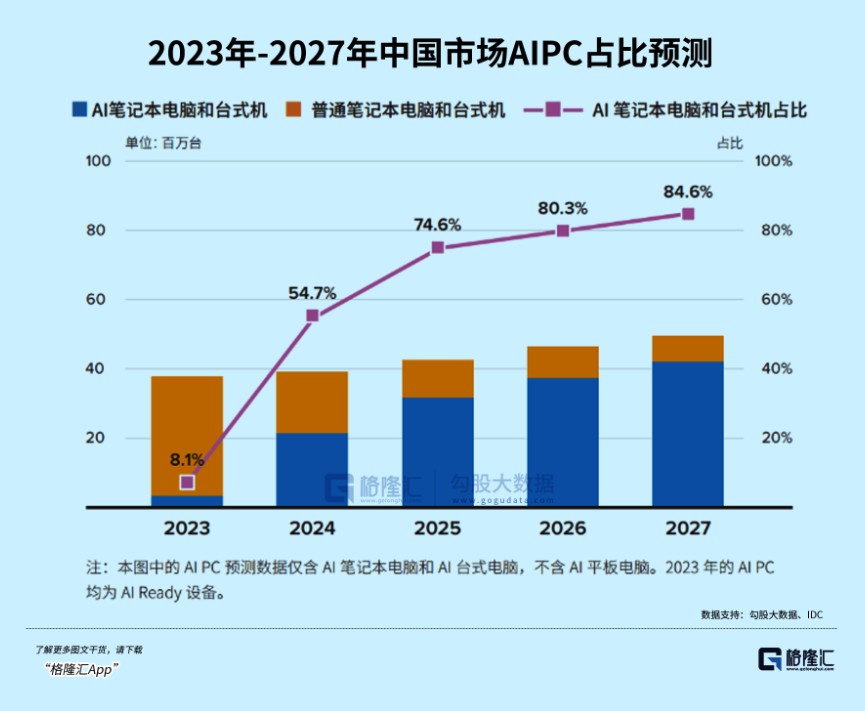

行业“老炮儿”亟待抓住多年未见的机遇,据英特尔称,2028年,AIPC将占PC市场的80%。

据IDC预测,AIPC(不含平板)在中国PC市场中新机的装配比例将从今年的8%增长到2027年的85%,对应市场规模将从2023年的141亿攀升至2027年的1312亿,增长超过8倍。

但有一个前提是,端侧要先解决如何将大模型压缩到适合终端的规模而保证核心能力不流失。

对设备厂商来说,这是一大挑战,但也大机遇。谁能先解决,谁就能率先吃到最丰厚的红利。

一种解决方法是提升小模型的性能,专注小而美。

比如微软训最近练出的Phi-2凭借27亿参数,在测试中几乎打穿了所有130以下的大模型,包括谷歌最新发布的Gemini Nano 2;与25倍体量的Llama-2模型相比,它在多步推理任务(即编码和数学)上的性能甚至还要更好。

但就AIPC而言,传统的以CPU为主的算力架构已经难以满足AI神经网络并行运算的要求,英特尔为此提出“XPU”的方案,即CPU+NPU+GPU。结合NPU高能效低功耗、CPU适合轻量级,单次推理任务,GPU负责并行计算的高吞吐场景等特点,更加灵活地应对不同场景的AI算力需求。

据悉,微软内置Copilot的PC对算力的要求门槛是40TOPS。高通新款PC处理器骁龙X Elite,整体AI引擎可以提供75TOPS的算力。

而AMD将于2024年推出的Ryzen 8000系列同样也能达标。

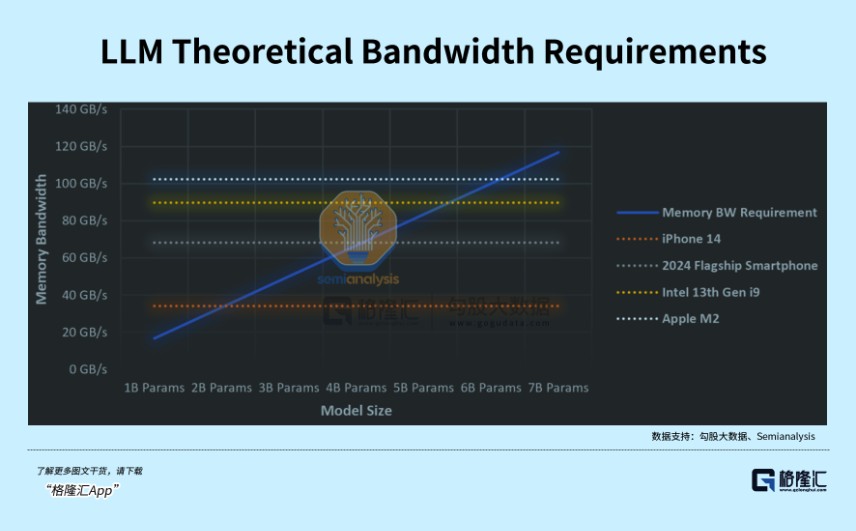

但总体来看,“每个人都能用上AI”的愿景目前来看还是奢侈的,因为AI功能而扩展的硬件升级要求除了加速处理器,还有高内存带宽,低功耗。终端能否跑通上百亿甚至上千亿的大模型,不仅取决于能否跑得动,还取决于内存是否装得下。

目前大多数电脑的内存容量是8GB,但运行一个70亿参数的大语言模型,在16位的精度下至少也需要14GB内存。一种可行的解决方案是通过对模型量化压缩来减小内存占用,一个七十亿参数的模型如果经过量化,大概能缩至2G-4G的运行内存,这样手机端才能装得下。

同时,大多数手机和PC的传输速度都在1GB/s以下,最快的PC存储驱动器最多可达到6GB/s。在1GB/s和4位量化下,也只能运行约20亿大小的模型。

不过,从另一面视角来看,这恰恰正是设备商们的时代性的超级机遇。

因为由AI驱动的换机潮,势必会出现。

无论是手机,还是PC端,带来的市场规模将会是无比庞大的。

PC重生

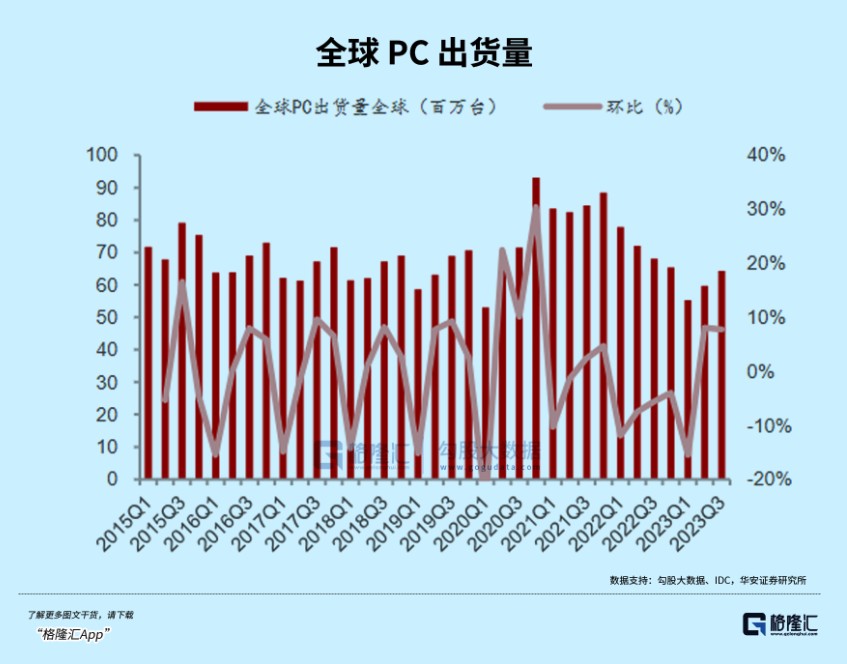

个人电脑、手机先后于2011年,2016年步入存量市场,2020年后由于线上办公需求增加,透支的需求使得PC出货量在21年达到3.4亿台的峰值,此后需求持续低迷,出货量骤降,库存叠加,传统PC的自然换机周期缺乏技术创新的驱动力。

据IDC,今年前三季度全球PC出货量同比下降17.1%合计1.87亿台,跌到了2005年的水平。

经过两年的调整,个人PC市场已经处在出货量和库存周期的底部,新一轮换机周期也即将恰逢其时。

一方面,三季度的全球PC出货量环比增长了11%,同比降幅缩窄至7.6%。经历了一年多的去库存阶段,主流厂商如联想、惠普、戴尔当前的库存水位已达到较为健康的水平,去化接近尾声。

另一方面,Windows 10即将于2025停更,配置Copilot的新系统或需要更高配置的电脑支撑。根据微软官网披露信息,Windows 10将于2025年10月14日停更,届时仅支持Windows 10或更低系统配置的个人电脑将难以适用。

Gartner认为,个人PC市场已经触底,库存随着教育市场的季节性需求和假日销售将逐渐恢复正常,预计2024 年全球PC市场将增长4.9%。

目前,英特尔正在与100多家软件厂商合作,为PC市场带来数百款AI增强型应用,这些极具创造力、生产力和趣味性的应用将变革PC体验。

之前英伟达黄仁勋也说过:“PC行业正迎来一次重生的机遇。在未来10年,新的AI PC将取代传统PC,市场价值可达上万亿美元。”

大佬们都这么说,也这么开始着手了,如果我们依旧对这个行业莫不关心,或许又将会错过一个难得的机遇。

本文为专栏作者授权创业邦发表,版权归原作者所有。文章系作者个人观点,不代表创业邦立场,转载请联系原作者。如有任何疑问,请联系editor@cyzone.cn。