编者按:本文来自微信公众号 腾讯科技(ID:qqtech),作者:郭晓静,编辑:徐青阳,创业邦经授权转载。

世界顶尖的AI模型可以通过医学执照考试,可以编写复杂代码,甚至能在数学竞赛中击败人类专家,但是却在一款儿童游戏中《宝可梦》屡屡受挫。

这场引人瞩目的尝试始于2025年2月,当时Anthropic的一名研究人员推出了“Claude玩《宝可梦红》”的Twitch直播,以此配合Claude Sonnet 3.7的发布。

2000名观众涌入直播间。在公共聊天区,观众们为Claude出谋划策、加油打气,使这场直播逐渐演变为一场围绕AI能力展开的公开观察。

Sonet3.7只能说是“会玩”《宝可梦》了,但“会玩”不等于“能赢”。它会在关键节点卡住数十小时,还会做出连儿童玩家都不会犯的低级错误。

这不是Claude第一次尝试。

早期版本的表现更加灾难:有的在地图中毫无目标地游荡,有的陷入无限循环,更多的甚至无法走出新手村。

即便是能力显著提升的Claude Opus 4.5,仍会出现令人费解的失误。有一次,它在“道馆外“绕圈整整四天,却始终未能进入,原因仅仅是没意识到需要砍倒挡在路口的一棵树。

一款儿童游戏,为何成了AI的滑铁卢?

因为《宝可梦》要求的,恰恰是当今AI最缺乏的能力:在没有明确指令的开放世界中持续推理、记忆数小时前的决策、理解隐含的因果关系、在数百个可能的行动中做出长期规划。

这些事情对8岁孩子来说轻而易举的事,对标榜"超越人类"的AI模型却是不可逾越的鸿沟。

工具集差距决定成败?

相比之下,谷歌的Gemini 2.5 Pro在2025年5月成功通关了一款难度相当的《宝可梦》游戏。谷歌首席执行官桑达尔·皮查伊(Sundar Pichai)甚至在公开场合半开玩笑地表示,公司在打造“人工宝可梦智能”方面迈出了一步。

然而,这一结果并不能简单归因于Gemini模型本身更“聪明”。

关键差异在于模型所使用的工具集。负责运营Gemini《宝可梦》直播的独立开发者乔尔·张(Joel Zhang)将工具集比喻为一套“钢铁侠装甲”:AI并非赤手空拳进入游戏,而是被置于一个可调用多种外部能力的系统中。

Gemini的工具集提供了更多支持,例如将游戏画面转写为文本,从而弥补模型在视觉理解上的弱点,并提供定制化的解谜与路径规划工具。相比之下,Claude所使用的工具集更为简约,它的尝试也更直接地反映出模型自身在感知、推理与执行上的真实能力。

在日常任务中,这类差异并不明显。

当用户向聊天机器人提出需联网查询的请求时,模型同样会自动调用搜索工具。但在《宝可梦》这类长期任务中,工具集的差异被放大至足以决定成败的程度。

回合制暴露AI的“长期记忆”短板

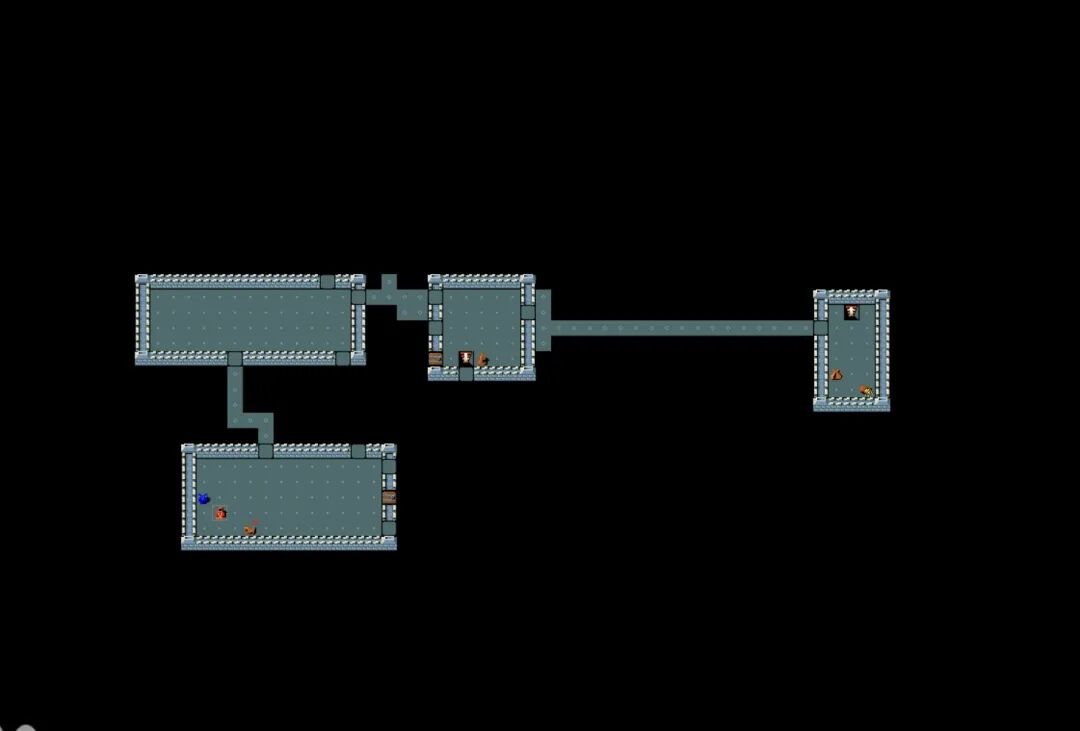

由于《宝可梦》采用严格的回合制且无需即时反应,它成为了测试 AI 的绝佳“练兵场“。AI 在每一步操作中,只需结合当前画面、目标提示与可选操作进行推理,即可输出‘按A键’这类明确的指令。

这似乎正是大语言模型最擅长的交互形式。

症结恰恰在于时间维度的“断层”。 尽管 Claude Opus 4.5 已累计运行超 500 小时、执行约 17 万步,但受限于每一步操作后的重新初始化,模型只能在极窄的上下文窗口中寻找线索。这种机制让它更像是一个靠便利贴维持认知的失忆者,在碎片化的信息中循环往复,始终无法像真正的人类玩家那样,实现从量变到质变的经验跨越。

在国际象棋和围棋等领域,AI系统早已超越人类,但这些系统是为特定任务高度定制的。相比之下,Gemini、Claude和GPT作为通用模型,在考试、编程竞赛中频频击败人类,却在一款儿童向游戏中屡屡受挫。

这种反差本身便极具启示性。

在乔尔·张看来,AI面临的核心挑战在于无法在长时间跨度内持续执行单一明确目标。“如果你希望智能体完成真正的工作,它不能忘记五分钟前自己做了什么,”他指出。

而这种能力,正是实现认知劳动自动化不可或缺的前提。

独立研究者彼得·惠登(Peter Whidden)给出了更直观的描述。他曾开源一个基于传统AI的《宝可梦》算法。“AI对《宝可梦》几乎无所不知,”他表示,“它在海量人类数据上训练,清楚知道正确答案。但一到执行阶段,就显得笨拙不堪。”

游戏中,这种“知道却做不到”的断层被不断放大:模型可能知道需寻找某道具,却无法在二维地图中稳定定位;知道应与NPC对话,却在像素级移动中反复失败。

能力演进背后:未跨越的“本能”鸿沟

尽管如此,AI的进步仍清晰可见。Claude Opus 4.5在自我记录和视觉理解上明显优于前代,得以在游戏中推进更远。Gemini 3 Pro在通关《宝可梦蓝》后,又完成了难度更高的《宝可梦水晶》,且全程未输一场战斗。这是Gemini 2.5 Pro从未实现的。

与此同时,Anthropic推出的Claude Code工具集允许模型编写并运行自有代码,已被用于《过山车大亨》等复古游戏,据称能成功管理虚拟主题公园。

这些案例揭示了一个不直观的现实:配备合适工具集的AI,可能在软件开发、会计、法律分析等知识工作中展现极高效率,即便它们仍难以应对需要实时反应的任务。

《宝可梦》实验还揭示另一耐人寻味的现象:在人类数据上训练的模型,会表现出近似人类的行为特征。

在Gemini 2.5 Pro的技术报告中,谷歌指出,当系统模拟“恐慌状态”,如宝可梦即将昏厥时,模型的推理质量会显著下降。

而当Gemini 3 Pro最终通关《宝可梦蓝》时,它为自己留下了一段非任务必需的备注:“为了诗意地结束,我要回到最初的家,与母亲进行最后一次对话,让角色退休。”

在乔尔·张看来,这一行为出乎意料,还带有某种人类式的情感投射。

AI难以逾越的“数字长征”,远不止《宝可梦》

《宝可梦》并非孤例。在追求通用人工智能(AGI)的道路上,开发者发现,即便AI能在司法考试中名列前茅,在面对以下几类复杂游戏时,依然面临着难以逾越的“滑铁卢”。

《NetHack》:规则的深渊

这款80年代的地牢游戏是AI研究界的“噩梦”。它的随机性极强且有“永久死亡”机制。Facebook AI Research发现,即便模型能写代码,但在需要常识逻辑和长期规划的《NetHack》面前,表现甚至远逊于人类初学者。

《我的世界》:消失的目标感

虽然AI已能制作木镐甚至挖掘钻石,但独立“击败末影龙”仍是幻想。在开放世界里,AI经常会在长达数十小时的资源收集过程中“忘记”初衷,或在复杂的导航中彻底迷路。

《星际争霸 II》:通用性与专业的断层

尽管定制化模型曾击败职业选手,但若让Claude或Gemini直接通过视觉指令接管,它们便会瞬间崩盘。在处理“战争迷雾”的不确定性,以及平衡微操与宏观建设方面,通用模型依然力不从心。

《过山车大亨》:微观与宏观的失衡

管理乐园需要追踪数千名游客的状态。即便具备初步管理能力的Claude Code,在处理大规模财务崩溃或突发事故时也极易疲态。任何一次推理断层,都会导致乐园破产。

《艾尔登法环》与《只狼》:物理反馈的鸿沟

这类强动作反馈游戏对AI极不友好。目前的视觉解析延迟意味着,当AI还在“思考”Boss动作时,角色往往已经阵亡。毫秒级的反应要求,构成了模型交互逻辑的天然上限。

为何《宝可梦》成为AI试金石?

如今,《宝可梦》正逐渐成为AI评估领域中一种非正式却极具说服力的测试基准。

Anthropic、OpenAI和谷歌的模型在Twitch上的相关直播累计吸引数十万条评论。谷歌在技术报告中详细记录Gemini的游戏进展,皮查伊在I/O开发者大会上公开提及此项成果。Anthropic甚至在行业会议中设立“Claude玩宝可梦”展示区。

“我们是一群超级技术爱好者,”Anthropic应用AI负责人大卫·赫尔希(David Hershey)坦言。但他强调,这不仅是娱乐。

与一次性问答式的传统基准不同,《宝可梦》能在极长时间内持续追踪模型的推理、决策与目标推进过程,这更接近现实世界中人类希望AI执行的复杂任务。

截至目前,AI在《宝可梦》中的挑战仍在继续。但正是这些反复出现的困境,清晰勾勒出通用人工智能尚未跨越的能力边界。

本文为专栏作者授权创业邦发表,版权归原作者所有。文章系作者个人观点,不代表创业邦立场,转载请联系原作者。如有任何疑问,请联系editor@cyzone.cn。